数据治理与数据处理服务 构建高效、可信的数据价值体系

在当今数据驱动的时代,企业及组织的数据资产规模呈指数级增长,数据治理与专业的数据处理服务已成为释放数据价值、保障数据安全、支撑智能决策的核心基石。有效进行数据治理并善用数据处理服务,是构建高效、可信数据能力的关键路径。

一、 数据治理:奠定坚实的数据管理基础

数据治理并非单一的技术项目,而是一套贯穿数据全生命周期的管理体系,旨在确保数据的质量、安全、一致性与可用性。其核心目标是将数据转化为可信、可用的战略资产。

- 建立治理框架与组织保障

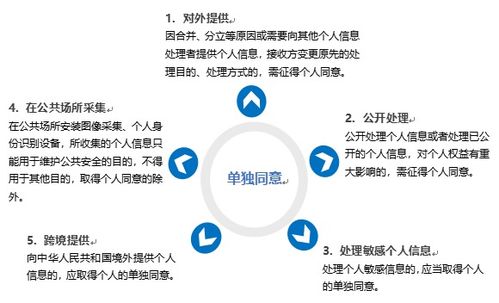

- 制定顶层战略与政策:明确数据治理的目标、原则与范围,使其与业务战略对齐。制定数据标准、数据安全、数据质量、数据隐私(如GDPR、个人信息保护法合规)等核心政策。

- 设立专门的组织与角色:成立数据治理委员会(或领导小组),明确数据所有者、数据管家、数据管理员等角色职责,确保权责清晰,跨部门协同顺畅。

- 聚焦核心治理领域

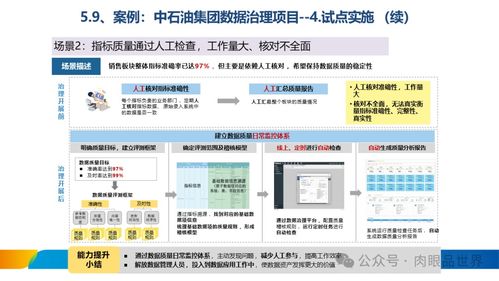

- 数据质量管理:建立数据质量评估标准(如准确性、完整性、一致性、时效性),实施数据质量检查、监控、清洗与提升的闭环流程。从源头把控,持续优化。

- 元数据与数据资产管理:建立统一的元数据管理,清晰定义数据的业务含义、技术属性、血缘关系及生命周期。形成数据资产目录,使数据“可见、可查、可理解、可用”。

- 数据安全与隐私保护:实施数据分级分类,根据敏感级别定义访问控制策略。采用加密、脱敏、审计等技术手段,确保数据在存储、传输、使用过程中的安全,并满足合规要求。

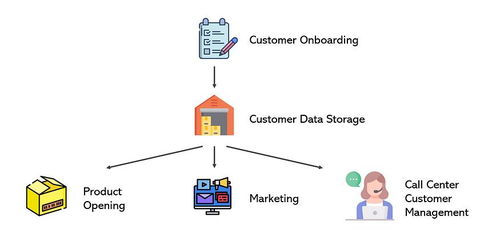

- 主数据与参考数据管理:统一管理客户、产品、供应商等关键业务实体(主数据)及状态、类型等标准代码(参考数据),确保核心数据在全组织内的一致性与准确性。

二、 数据处理服务:驱动数据价值的高效转化

数据处理服务是将原始数据转化为可用信息和知识的一系列技术与操作。高效的数据处理服务依赖于强大的治理基础,并反过来促进治理目标的落地。

- 构建现代化的数据处理架构

- 采用混合架构:结合数据湖(存储原始、多样数据)与数据仓库(存储清洗、建模后的主题数据)的优势,构建湖仓一体架构,满足灵活探索与高性能分析的双重需求。

- 拥抱云原生服务:利用云服务商(如AWS, Azure, 阿里云等)提供的弹性计算、存储及托管数据处理服务(如EMR、Databricks、数据工厂),降低运维成本,提升扩展性与敏捷性。

- 实施全链路的数据处理流程

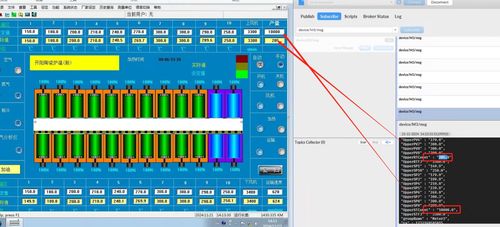

- 数据集成与 ingestion:通过ETL/ELT工具、CDC(变更数据捕获)、消息队列等技术,高效、实时地从异构数据源(数据库、日志、IoT设备、外部API)采集数据。

- 数据清洗与转换:基于数据治理中定义的质量规则和标准,对数据进行清洗、去重、格式化、标准化和丰富化,为后续分析提供高质量输入。

- 数据建模与开发:根据业务需求,设计维度模型、数据宽表或机器学习特征,通过SQL、Spark、Flink等工具进行数据加工与聚合,构建服务于报表、分析、AI应用的数据层。

- 数据服务与交付:通过数据API、数据集市、分析平台、BI工具等方式,将处理好的数据安全、便捷地交付给业务用户、分析师和应用程序,实现数据消费。

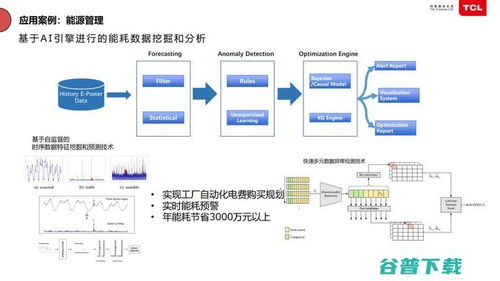

- 引入自动化与智能化

- 自动化运维与监控:对数据处理任务的调度、执行、性能及数据质量进行全方位监控与告警,实现故障自愈与性能优化。

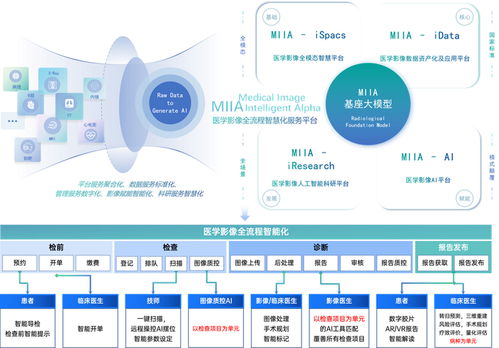

- 智能化数据管理:利用AI/ML技术进行智能数据分类、异常检测、根因分析及自动化的数据质量修复建议,提升处理效率与智能化水平。

三、 治理与服务协同:实现数据价值的闭环

数据治理与数据处理服务并非割裂,而是相辅相成的统一体:

- 治理指导处理:数据治理的规范与策略(如质量标准、安全策略)必须嵌入到数据处理流程的设计与执行中,确保产出的数据产品合规、可信。

- 处理赋能治理:高效的数据处理能力(如血缘分析、影响分析、质量监控)为治理的落地提供了技术支撑和反馈闭环,使治理规则得以动态优化。

- 文化与工具并重:除了技术和流程,培养组织的数据文化,提升全员的数据素养,并选择或开发适配的数据治理与处理平台工具,是成功的关键保障。

###

有效的数据治理是“规则与保障”,专业的数据处理服务是“引擎与执行”。二者紧密结合,方能将海量、原始的“数据矿石”系统性地冶炼成高质量、高价值的“信息金砖”,并安全、高效地输送到业务前线,最终驱动企业实现基于数据的精准决策、卓越运营与创新增长。这是一个需要持续投入、迭代优化的战略旅程。

如若转载,请注明出处:http://www.591guke.com/product/39.html

更新时间:2026-02-27 21:04:31